الذكاء الاصطناعي.. إليك 6 طرق للاستفادة من مميزاته وتفادي عيوبه

الضجة التي يثيرها روبوت الدردشة ChatGPT من ميكروسوفت وصلت إلى حد تحذير خبراء كبار من مخاطر الذكاء الاصطناعي، فهل تحمل القصة "تهويلاً"؟ وكيف يمكن الاستفادة من مزاياه وتفادي مخاطره؟

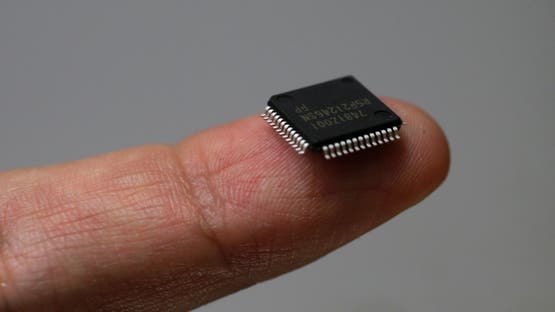

كان "ChatGPT" أو روبوت الدردشة القائم على الذكاء الاصطناعي، الذي تصنعه شركة "أوبن إيه آي"، في كاليفورنيا، قد أثار عاصفة من الجدل هذا العام، تبعتها تحذيرات خطيرة من جانب مشاهير ومتخصصين في مجال التكنولوجيا.

وخلصت دراسة استقصائية حديثة إلى أن 50% من الباحثين العاملين في مجال الذكاء الاصطناعي يرون أن هذه التكنولوجيا يحتمل بنسبة 10% أن تتسبب في انقراض الجنس البشري.

لماذا نخاف من الذكاء الاصطناعي؟

وقد يتساءل البعض: ما دام الباحثون يرون أن الذكاء الاصطناعي يمثل خطراً داهماً لهذه الدرجة، فلمَ لا يترك هؤلاء الباحثون جميعاً وظائفهم؟ والواقع أن أحدهم ترك عمله بالفعل الأسبوع الماضي.

جيوفري هينتون، العالم الرائد في مجال التعلم الآلي، الذي يستند إليه الذكاء الاصطناعي، استقال من عمله بشركة جوجل التكنولوجية العملاقة، وأرجع هينتون استقالته إلى مخاوف لديه من السباق الجاري بين شركات التكنولوجيا لتطوير تقنيات الذكاء الاصطناعي التوليدي (مثل تطبيق المحادثة ChatGPT من شركة مايكروسوفت، وتطبيق Bard من شركة جوجل) ونشرها، والذي شعر بأنه سباق غير محكوم بدواعي المسؤولية؛ لأنه يفتقر إلى الضوابط التنظيمية اللازمة.

وقال: "من الصعب أن تجد طريقة واضحة تمنع بها الجهات السيئة من استخدام [تطبيقات الذكاء الاصطناعي] في فعل أشياء سيئة".

بعد أيام من استقالة هينتون، استُدعي المديرون التنفيذيون لبعض شركات الذكاء الاصطناعي الرائدة إلى اجتماع في البيت الأبيض، وأُنذروا بأن الحكومة الأمريكية قد تفرض عليهم لوائح جديدة، إن لم يكبحوا التطورات الخطيرة المحتملة للذكاء الاصطناعي.

ونشرت صحيفة The Times البريطانية تقريراً يرصد أبرز سبب للخوف من هذه التكنولوجيا، وهو أن لديها القدرة على اختراق العديد من مجالات حياتنا وإحداث أضرار مؤثرة فيها، سواء كان ذلك بالتدمير المحتمل لكثير من الوظائف أم بتطوير أنظمة الأسلحة المستقلة [قليلة التدخل البشري] التي يمكن أن تنتهك قوانين الحرب.

كما أن سبب أكثر قوة للخشية من الذكاء الاصطناعي، أنه قد يزيد من الاستغناء عن التفاعلات اليومية بين البشر، ويسوقنا عما قريب إلى العيش في عالم أكثر بُعداً عن القيم الإنسانية.

هذه بعض القضايا التي عُني بدراستها الباحثون في "معهد أخلاقيات الذكاء الاصطناعي" التابع لجامعة أكسفورد البريطانية منذ تأسيسه قبل 3 سنوات.

وقد تعاون خبراء في العلوم الإنسانية والعلوم المادية معاً لتقييم تأثيرات الذكاء الاصطناعي التي يمكن أن تحدث؛ والتأثيرات التي ينبغي التطلع إلى حدوثها في مختلف القضايا، مثل الخصوصية والتعليم وحتى الديمقراطية؛ فضلاً عن البحث عن أصلح السبل للتعامل مع هذه التأثيرات.

وقدّمت الصحيفة البريطانية 6 طرق يمكن بها احتواء مخاطر الذكاء الاصطناعي، على النحو التالي:

1. لا تقع فريسة لتجار التخويف من نهاية العالم

لطالما كانت هناك فجوة زمنية بين التقدم التكنولوجي والاستجابة التنظيمية بالقواعد واللوائح التي تقوِّم هذا التقدم، لكن المخاطر تتضخم في حالة الذكاء الاصطناعي؛ لقدرته غير المسبوقة على تنفيذ المهام التي كان البشر وحدهم من يستطيعون القيام بها في مختلف المجالات، من كتابة التعليمات البرمجية إلى التشخيص الطبي.

لذلك، فإننا يجب أن نتعامل مع مخاوف خبراء الذكاء الاصطناعي بجدية، لكننا ينبغي أن ننتبه كذلك إلى بضعة أشياء: أولها، أن هؤلاء الخبراء بشر، ومن ثم فهم عرضة مثلنا للوقوع تحت تأثير الأعطاب النفسية المعهودة عن البشر، مثل التنبؤ بنهاية العالم والتخويف منها، وقد تستحوذ عليهم الرهبة من مثل هذه التكنولوجيا هائلة القوة.

وثانيها، أن هناك نزوعاً لدى كل فرد منا إلى المبالغة في أهمية تخصصه وتأثيراته، سواء أكانت تلك التأثيرات في سبيل الخير أم في الشر. وثالثاً، أن مجال الذكاء الاصطناعي -مثل أي مجال أكاديمي آخر- ينطوي على خلافات بين علمائه حول أسباب خطورته ومكامن هذا الخطر إن وجد؛ فتجد بعضهم يُنذر بأن العالم بات قاب قوسين أو أدنى من الوقوع تحت هيمنة أنظمة الذكاء الاصطناعي المكافئة للبشر، والقادرة على التفوق عليهم وحتى التخلص منهم.

وتجد بعضهم يستشهد بنبوءات كاذبة عن استيلاء السيارات ذاتية القيادة على شوارعنا. والواقع أن "الذكاء الاصطناعي العام" لا يزال أمامه عقود من البحث والتطوير، وقد يتطلب التعامل معه أن نتوصل إلى نهج جديد تماماً لا يمكننا التنبؤ به بعد.

2. أشياء لا تحتاج للاعتماد على الذكاء الاصطناعي

في الوقت الحالي، غالباً ما يُوصف تطور الذكاء الاصطناعي بأنه صيرورة من التحولات التي لا يمكن إيقافها، ومع ذلك فإن تنظيم هذه التحولات هو في نهاية المطاف، قضية أخلاقية.

والأسئلة المتعلقة بكيفية التعامل مع الذكاء الاصطناعي واستخداماته لا تكاد تحصى، سواء أكان السؤال عن أخلاقية الاعتماد على روبوت اجتماعي للاستغناء به عن رفقة والديك المسنين؛ أم كان السؤال عن القوانين الوطنية والمعاهدات الدولية التي سنختارها لتنظيم التعامل مع الذكاء الاصطناعي؛ أم غير ذلك من الأسئلة الأخلاقية.

ففي النهاية، الأمر متروك لنا، أفراداً وجماعات، لتحديد الدور الذي يضطلع به الذكاء الاصطناعي في حياة الإنسان. كما أنه ليس من المقبول أن نتهرب من المسؤولية بإقناع أنفسنا أن الذكاء الاصطناعي ليس إلا ألعوبة في أيدي سوق لا رادع لها، والتسليم بهيمنة محتومة للشركات التكنولوجية الكبرى.

وقد أكد البيت الأبيض في اجتماعه برواد الذكاء الاصطناعي أن رغبة الشركات في بلوغ الهيمنة على السوق لا تبرر إطلاقاً إصدار تطبيقات لم يكتمل اختبارها، ولا تسوغ تعريض الناس للخطر.

3. الحاجة لتنظيم قوانين تراعي البعد التكنولوجي

ينبغي أن نتعلم من خبراتنا السابقة في تنظيم التكنولوجيا، وألا ننقاد بدافع الارتباك إلى الافتراض بأن التكنولوجيا المختلفة جذرياً عن سابقاتها لا بد أن نستحدث لها مخططات تنظيمية جديدة جذرياً.

وكشف بعض الخبراء في قوانين الذكاء الاصطناعي، مثل سيمون شسترمان، مدير قسم حوكمة الذكاء الاصطناعي في جامعة سنغافورة الوطنية، أن كثيراً من أخطار الذكاء الاصطناعي يمكن التعامل معها بتطبيق بعض المبادئ القانونية العامة الموجودة لدينا من قبل. ومنها على سبيل المثال، أن ننسب مسؤولية القرارات التي تتخذها أنظمة الذكاء الاصطناعي إلى المستخدم والمصنِّع والبائع، والحكم على كل حالة بحسبها.

والمقصود أن السعي لتطوير خطة شاملة من القوانين واللوائح المفصلة خصيصاً للتعامل مع التكنولوجيا الجديدة يعرِّضنا لإنتاج منظومة قانونية مفرطة التعقيد ولا تقوم على مبادئ وجيهة.

4. التوقف عن اتباع "الخبراء الأخلاقيين"

كثيراً ما تختزل المناقشات المتعلقة بالذكاء الاصطناعي الأسئلة الأخلاقية، إذ تعدُّها مجرد مسائل يجب أن يوكل حلها إلى المتخصصين التقنيين. ويقول عالم الذكاء الاصطناعي الرائد، ستيوارت راسل، إن مدار الأسئلة الأخلاقية هو تحديد الخيارات التي يجدر بالبشرية أن تميل إليها، والسعي إلى تحقيقها بأكبر قدر ممكن. لكن خيارات الإنسان كثيراً ما تستند إلى تصورات خاطئة أو تعكس أفكاراً خبيثة، مثل العنصرية والتمييز على أساس الجنس.

لذلك، فإننا يجب ألا نترك الأمر برمته ليحكم فيه خبراء الذكاء الاصطناعي، بل ينبغي تعزيز المناقشات الديمقراطية حول الذكاء الاصطناعي بإشراف من مواطنين مطلعين وممكَّنين.

وفي هذا السياق، تعتبر التوعية قضية لا غنى عنها، إذ يجب العمل على محو الأمية الرقمية بين أطياف المجتمع كافة. لأننا لن نضمن الاستماع إلى وجهات النظر المختلفة – ومنها حتى آراء المتطرفين في بغضهم لتطبيقات الذكاء الاصطناعي، مثل الذين تسببت الأتمتة في تحولهم إلى عاطلين عن العمل- إلا إذا نشرنا الوعي بهذه القضايا على نطاق واسع.

ومن الأمثلة الجديرة بالالتفات إليها في هذا السياق: مثال تايوان، حيث كانت أودري تانغ، وزيرة الشؤون الرقمية في البلاد، في طليعة الساعين إلى استخدام التكنولوجيا الرقمية لتعزيز مشاركة المواطنين. وأنشأت الحكومة التايوانية منصةَ مناقشات تسمى Polis، لجمع وتحليل آراء المواطنين، وتقديمها في رؤى مصاغة لتوجيه صناع السياسات.

5. السعي إلى هدنة في سباق التسلح بالذكاء الاصطناعي

تحول سباق الهيمنة على الذكاء الاصطناعي إلى سباق عالمي، فالصين تنافس الولايات المتحدة في القيادة. وأي دولة تتباطأ في خطواتها بداعي المخاوف الأخلاقية تخاطر بمنح الأفضلية لمنافسيها في هذا السباق.

لذلك، فإن العالم في حاجة ملحة إلى إنشاء نظام عالمي لتنظيم التعامل مع الذكاء الاصطناعي، على غرار المنظومة العالمية للحد من استخدام الأسلحة النووية في المواجهات بين القوى العظمى.

وقد يبدو الاتفاق العالمي على هيكل واسع لتنظيم التعامل مع تقنيات الذكاء الاصطناعي أمراً بعيد المال حتى الآن، ومع ذلك فإن علينا أن نسعى لبلوغ هذا الاتفاق، لأننا في أمس الحاجة إلى وضع الحد الأدنى من المعايير اللازمة لتنظيم الذكاء الاصطناعي، والتوافق على القواعد التي يمكن للدول والأيديولوجيات المختلفة قبولها في هذا السياق.

6. العمل على استخدام الذكاء الاصطناعي بشكل متوازن

في الختام، من المهم ألا نغفل الإمكانات غير العادية للذكاء الاصطناعي لإثراء حياتنا ومجتمعاتنا واقتصاداتنا. فالذكاء الاصطناعي سيواصل ثورته في مختلف المجالات الطبية، مثل اكتشاف عقاقير جديدة؛ وتعزيز قدرات التشخيص المبكر للأمراض؛ وتوسيع إدراكنا لبيولوجيا الإنسان والأحياء؛ وإدارة عمليات المراقبة على الصحة العامة والسياسات الصحية. وسيساعدنا الذكاء الاصطناعي كذلك على فهم التغير المناخي، وتعزيز التعاون بين البشر لتخفيف تداعياته. وقد بدأ الفنانون والموسيقيون في استخدام هذه التقنيات بالفعل في مجالاتهم.

(عربي بوست)